Mens - Robot Interactie

“Hey Siri, hoe versta jij mij?”

Dit is een stemassistent. Foto door Ben Kolde op Unsplash.

Stemassistenten, zoals Siri, zijn in de loop der jaren in populariteit gestegen. Juniper Research schatte dat er afgelopen februari meer dan 3 miljard spraakassistenten in gebruik waren! Om aan de behoeften van hun gebruikers te voldoen, moeten stemassistenten zich blijven verbeteren. Vorige maand kwam de nieuwste Alexa-update uit. Daardoor is Alexa nu in staat om u een vraag te stellen, in plaats van alleen maar te antwoorden. Hiervoor vroegen stemassistenten alleen ‘bedoelde je misschien …’ of zeiden ze simpelweg ‘ik begrijp je niet’. Nu kunnen ze om opheldering over een bepaald woord vragen en dat in de context kunnen plaatsen. Heb je je ooit afgevraagd hoe dit werkt?

Sommige stemassistenten, zoals Siri, staan op mobiele telefoons, maar andere zijn een volledig apparaat, zoals te zien is in de bovenstaande afbeelding. Ze zijn er om ons leven gemakkelijker te maken en te helpen bij het uitvoeren van kleine taken. Ze kunnen bijvoorbeeld snel een timer instellen of een vraag beantwoorden, zoals “wat is de lengte van‘Frozen II’?”.

Een volwaardig gesprek voeren is echter nog niet mogelijk. Een deel van de reden is de manier waarop mensen praten, maar dit wordt later in dit artikel besproken. Een andere reden is emotie. Dr. Arjan van Hessen, expert op het gebied van taalkunde en spraakherkenning en werkzaam aan de Universiteit van Utrecht, denkt dat de grootste uitdaging bij het ontwikkelen van spraakherkenning is om de apparaten emoties te laten detecteren en daar gepast op te laten reageren. Dit is volgens hem een reden voor grote bedrijven om geen gebruik te maken van spraakherkenning in hun callcenters. Communiceren via spraakherkenning is minder persoonlijk, wat misschien niet goed is voor bedrijven die reclame maken voor een persoonlijke benadering. Een andere reden om spraakherkenning niet te gebruiken, is als de oproep heel emotioneel is. Als je bijvoorbeeld een alarmnummer belt, wil je niet dat jouw emoties worden genegeerd.

In de meeste gevallen hoeft er echter geen rekening te worden gehouden met emoties. Bijvoorbeeld bij simpele vragen. Dit artikel is over die gevallen geschreven. Hoe weten stemassistenten wat er dan wordt gezegd?

Om Siri te gebruiken, moet het correct worden gekalibreerd door meerdere keren ‘Hé, Siri’ te zeggen. Siri weet dan hoe het klinkt als jij die zin uitspreekt. Hierna blijft je telefoon naar allerlei geluiden luisteren. Als het een geluid hoort dat erg lijkt op jouw versie van “Hé, Siri”, wordt het wakker en kun je alles vragen! Ook al is alleen “Hé Siri” gekalibreerd, worden bijna alle woorden die je zegt, moeiteloos herkend. Zelfs als je heel snel praat of als je een heel zwaar accent hebt, waardoor je misschien anders klinkt dan het gemiddelde. Hoe kan Siri nog steeds weten wat er wordt gezegd?

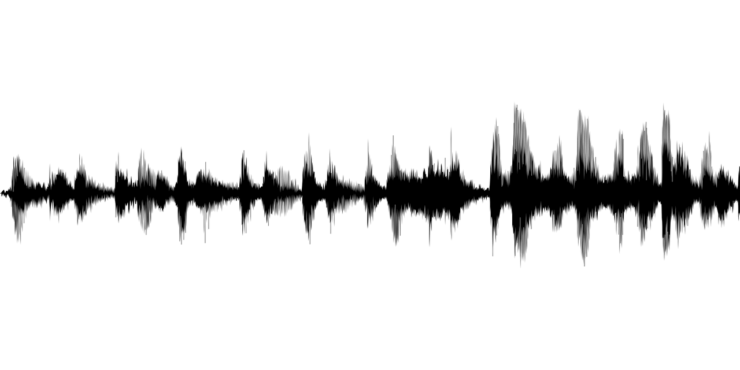

Geluid zoals geregistreerd door een telefoon. Afbeelding van Gordon Johnson via Pixabay.

Het antwoord op die vraag ligt in het opnemen van je stem. Bij opname door een telefoon ziet een stem eruit als in de afbeelding hierboven. De audio wordt vervolgens in zeer kleine stukjes van slechts één letter gesneden. Deze stukjes worden vervolgens vergeleken met hoe elke letter gemiddeld klinkt. Hierdoor wordt de waarschijnlijkheid berekend van welke letter het zou kunnen zijn. Siri is slim, want het gebruikt de vorige letters om te bepalen hoe waarschijnlijk het is dat de volgende letter iets is. Als de telefoon bijvoorbeeld denkt dat je tot nu toe ‘wate’ hebt gezegd, is de kans groter dat de volgende letter ‘r’ is om het woord ‘water’ af te sluiten dan ‘q’, aangezien ‘wateq’ geen woord is. Met deze methode hoort Siri alles nu 90% van de tijd correct!

Alleen de woorden kennen die worden gezegd, is echter niet voldoende om te antwoorden. Siri moet ook weten welke woorden belangrijk zijn. Dr. van Hessen vertelt dat mensen veel stopwoorden gebruiken wanneer ze met elkaar praten en vaak reageren met ‘ja’ of ‘uh-huh’ om te laten weten dat ze de ander begrepen hebben. Wíj weten dat die woorden niet belangrijk zijn, maar computers weten dat niet en proberen aan alles betekenis te geven. In de meeste gevallen concentreren ze zich echter niet op die woorden. Waarom niet?

Om te kunnen begrijpen wat belangrijk is in een zin, moeten stemassistenten een zin in stukken kunnen deconstrueren. Op school heb je verschillende soorten woorden geleerd, zoals zelfstandige naamwoorden, werkwoorden en bijvoeglijke naamwoorden. Siri kent ook dit soort woorden. Aan de hand van de plaatsing in een zin kan Siri erachter komen wat het woord betekent. In “ik eet sla” is het woord “sla” een zelfstandig naamwoord en verwijst naar voedsel. In “ik sla de vlieg” is het echter een werkwoord en betekent het geven van een klap. Door de plek in de zin, maat Siri dit onderscheid.

Een andere manier waarop Siri zinsstructuren gebruikt, is om het type vraag te identificeren. Je kunt vragen stellen als ‘waar is de dichtstbijzijnde bioscoop’. Siri weet dat dit een “waar”-vraag is, dus zoekt het naar een locatie. Het weet ook dat je het zelfstandig naamwoord “bioscoop” wil vinden en erkent dat je de locatie “dichtbij” wil hebben. Siri zoekt naar antwoorden op basis van de sleutelwoorden in de vraag.

Siri is niet de enige dat spraakherkenning gebruikt. Andere stemassistenten gebruiken deze methoden ook, en zelfs de game-industrie heeft er een toepassing voor gevonden. De app SpokeIt, die momenteel in ontwikkeling is, is ontworpen om op een leuke manier mensen te helpen met spraaktherapie. De spellen kunnen echter ook minder leerzaam zijn. In een horror spookjachtspel dat de gaming-gemeenschap de afgelopen twee weken heeft veroverd, kunnen de “geesten” hun eigen naam horen, de vragen die je aan ze stelt en ze kunnen gepast reageren.

Dus hoewel het begrijpen van emoties en betekenis achter woorden een geweldige uitdaging is, is spraakherkenning nu al zeer nauwkeurig en wordt het op veel manieren gebruikt. De technologie wordt steeds verder ontwikkeld en ik ben verheugd om te zien waar we vanaf hier naartoe gaan!